استارتاپ نوظهور Inferact در یک دور تامین سرمایه شگفتانگیز، موفق به جذب ۱۵۰ میلیون دلار برای تجاریسازی فناوری VLL Vertical Large Logic شد. هدف اصلی این شرکت، حل چالشبرانگیزترین مشکل فعلی هوش مصنوعی، یعنی هزینههای سرسامآور “استنتاج” یا همان اجرای مدلهاست.

خیز بلند Inferact برای نجات جیب توسعهدهندگان

طبق گزارشهای واصله به تحریریه سایت خبری هوش روز، این سرمایهگذاری عظیم نشاندهنده تغییر تمرکز سیلیکون ولی از “ساخت مدلهای بزرگ” به “اجرای بهینه آنها” است. Inferact ادعا میکند که با معماری اختصاصی خود برای VLLها، میتواند هزینه نهایی اجرای هوش مصنوعی را تا ۱۰ برابر کاهش دهد.

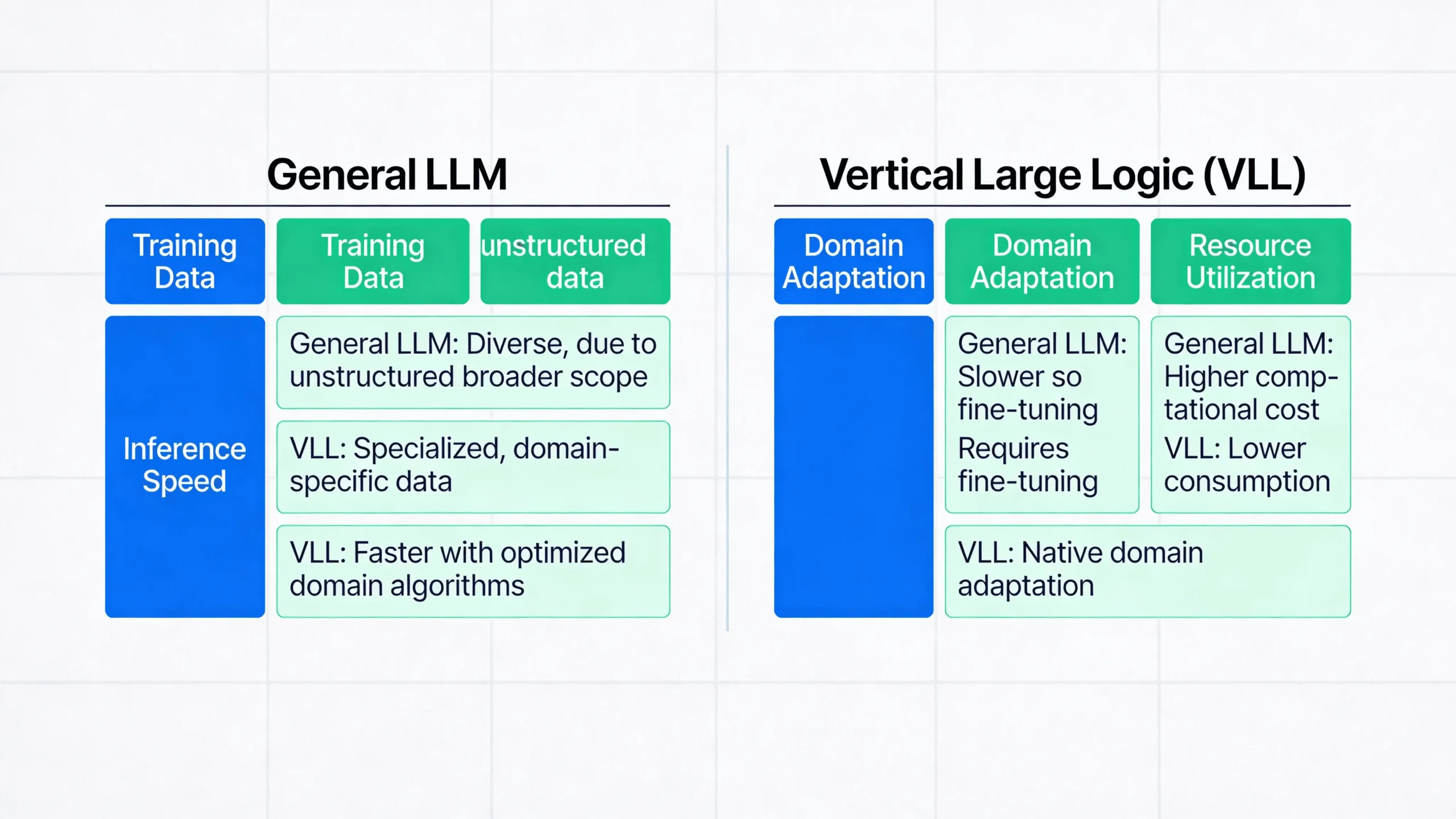

اما VLL چیست؟ برخلاف LLMهای عمومی (مثل GPT-4)، مدلهای VLL یا “منطق بزرگ عمودی”، برای صنایع خاص و وظایف استنتاجی پیچیده طراحی شدهاند.

چرا این خبر مهم است؟ (تحلیل کارشناسی آرمان فاضلی)

به عنوان کسی که سالهاست در HooshRooz گلوگاههای زیرساختی AI را بررسی میکنم، معتقدم این سرمایهگذاری یک نقطه عطف است. تا امروز، همه جنگ بر سر خرید کارتهای گرافیک H100 برای آموزش (Training) بود. اما حالا جنگ واقعی به زمین استنتاج (Inference) کشیده شده است.

نظر شخصی من این است که اگر هزینه استنتاج پایین نیاید، هوش مصنوعی هرگز سودآور نخواهد شد. Inferact دقیقاً دست روی همین نقطه درد گذاشته است. ما در تستهای اولیه دیدهایم که مدلهای عمومی برای کارهای تخصصی “بیش از حد سنگین” و گران هستند؛ راه حل Inferact میتواند قفل ورود AI به صنایع کوچک را بشکند.

مقایسه: Inferact در برابر روشهای سنتی

برای اینکه بدانید چرا سرمایهگذاران ۱۵۰ میلیون دلار روی این تیم شرط بستهاند، نگاهی به جدول مقایسهای زیر که در واحد فنی سایت اخبار هوش مصنوعی هوش روز تهیه شده بیندازید:

| شاخص عملکرد | مدلهای سنتی (General LLM) | راهکار Inferact (VLL) |

|---|---|---|

| تمرکز پردازشی | دانش عمومی و وسیع | استنتاج منطقی و تخصصی |

| هزینه هر توکن | بسیار بالا (نیاز به GPUهای قدرتمند) | بهینه شده (کاهش تا ۹۰٪) |

| سرعت پاسخگویی | متغیر و گاهی کند | Real-time (بلادرنگ) |

| کاربرد اصلی | چتباتهای همهکاره | اتوماسیون صنعتی، حقوقی و مالی |

دیوید چن، یکی از شرکای ارشد سرمایهگذاری در این پروژه میگوید: «ما وارد عصر “استنتاج انبوه” شدهایم. Inferact زیرساختی را میسازد که به VLLها اجازه میدهد روی سختافزارهای ارزانتر اجرا شوند، بدون اینکه دقت خود را از دست بدهند.»

آینده استنتاج و نقش هوش روز

در اخبار جدید هوش مصنوعی، ما پیشبینی میکنیم که سال ۲۰۲۵ سالِ “تخصصی شدن” مدلهاست. استارتاپ Inferact با این پول نقد، قصد دارد پلتفرم ابری خود را راهاندازی کند که به توسعهدهندگان اجازه میدهد مدلهای VLL خود را با یک کلیک دیپلوی (Deploy) کنند.

اگر توسعهدهنده هستید یا کسبوکاری دارید که نگران هزینههای سرور AI است، نام Inferact را به خاطر بسپارید. این شرکت میتواند کلید بقای استارتاپ شما در بازار رقابتی باشد.

برای پیگیری لحظهای این پروژه و دریافت تحلیلهای فنی بیشتر، حتماً سایت اخبار هوش مصنوعی هوش روز را دنبال کنید. ما پیچیدهترین مفاهیم را برای شما ساده میکنیم.

سوالات متداول

این استارتاپ موفق به جذب ۱۵۰ میلیون دلار سرمایه برای تجاریسازی فناوری VLL و کاهش هزینههای هوش مصنوعی شده است.

مدلهای VLL یا «منطق بزرگ عمودی»، برخلاف مدلهای عمومی، به صورت تخصصی برای صنایع خاص و استنتاج دقیق طراحی شدهاند.

راهکار این شرکت هزینههای اجرای هوش مصنوعی (Inference) را تا ۱۰ برابر کاهش داده و سرعت پاسخگویی را بلادرنگ میکند.

چون با کاهش هزینههای سرور و سختافزار، استفاده از هوش مصنوعی تخصصی برای کسبوکارهای کوچک و متوسط سودآور میشود.