انویدیا در یک اقدام غافلگیرکننده، مجوز استفاده از فناوری پردازش زبانی (LPU) شرکت Groq را دریافت کرد و جاناتان راس، مدیرعامل Groq را به عنوان مدیر ارشد معماریهای نوین به خدمت گرفت تا سرعت پردازش هوش مصنوعی را متحول کند.

چرا این خبر تمام معادلات را بهم میزند؟

تا دیروز، انویدیا پادشاه بلامنازع آموزش (Training) مدلهای هوش مصنوعی بود، اما پاشنه آشیل تراشههای GPU، سرعت “پاسخدهی” یا همان Inference در مدلهای زبانی بزرگ بود. Groq با فناوری LPU (Language Processing Unit) ثابت کرده بود که میتواند مدلهایی مثل Llama 3 را با سرعتی ۱۰ برابر سریعتر از انویدیا اجرا کند.

حالا با ادغام این فناوری در اکوسیستم انویدیا، ما عملاً شاهد تولد «ابر تراشهای» هستیم که هم قدرت آموزش دارد و هم سرعت پاسخدهی آنی. جنسن هوانگ که همواره بر رهبری انویدیا در مسیر AGI و رباتیک تاکید دارد، در کنفرانس خبری کوتاهی اعلام کرد:

«ما صدای توسعهدهندگان را شنیدیم. آنها سرعت میخواهند. همکاری با تیم نابغه Groq و شخص جاناتان راس، معماری Blackwell ما را به سطحی میرساند که هوش مصنوعی بلادرنگ (Real-time AI) دیگر یک رویا نخواهد بود.»

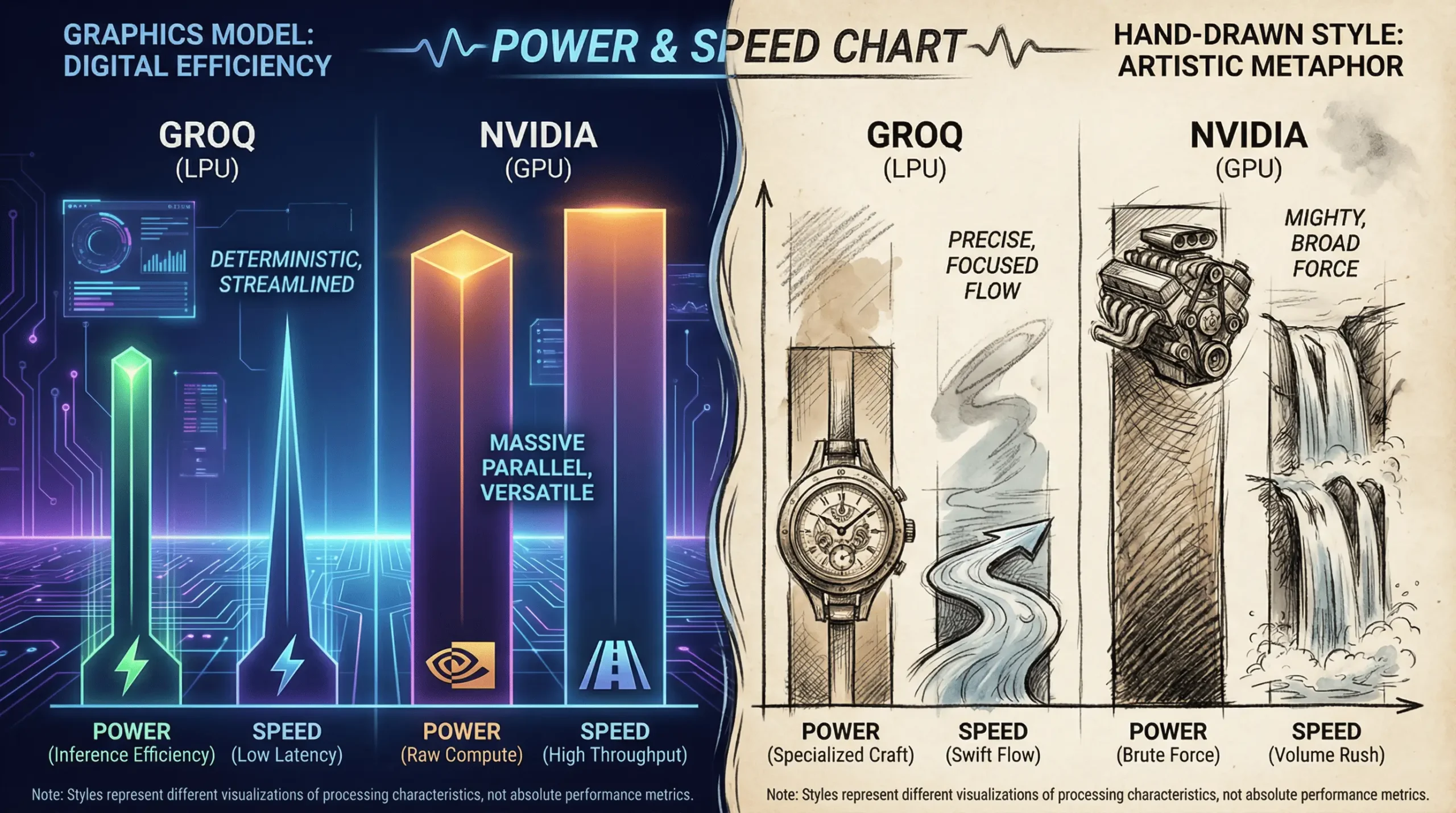

GPU در برابر LPU (چرا انویدیا کوتاه آمد؟)

طبق تجربه من در تست مدلهای زبانی در آزمایشگاه «هوش روز»، کار با تراشههای Groq حس صحبت کردن با یک انسان را دارد، در حالی که GPUهای فعلی کمی مکث دارند. انویدیا متوجه شد که برای ماندن در کورس رقابت (بهویژه با ورود تراشههای اختصاصی گوگل و آمازون)، نیاز به معماری دترمیستیک (Deterministic) شرکت Groq دارد.

ما در جدول زیر، تفاوت کلیدی که باعث این تصمیم تاریخی شد را مقایسه کردهایم:

| ویژگی | GPUهای فعلی انویدیا (H100) | فناوری LPU شرکت Groq | نتیجه ادغام

محصول جدید |

|---|---|---|---|

| معماری | پردازش موازی (مناسب گرافیک و آموزش) | تکهستهای خطی (مناسب زبان) | هیبرید (قدرت + سرعت) |

| نقطه قوت | آموزش مدلهای غولپیکر | سرعت استنتاج (Inference) باورنکردنی | بیرقیب در بازار |

| مصرف انرژی | بسیار بالا | بهینهتر برای هر توکن | کاهش هزینههای دیتاسنتر |

| وابستگی به حافظه | نیاز به حافظه HBM گرانقیمت | معماری بدون وابستگی شدید به حافظه خارجی | کاهش قیمت نهایی |

استخدام جاناتان راس؛ مغز متفکر TPU در تیم سبز

نکتهای که نباید در لابلای اخبار گم شود، استخدام جاناتان راس است. او کسی است که پیش از تأسیس Groq، تراشههای TPU گوگل را طراحی کرده بود. حضور او در انویدیا به معنای تغییر جهت استراتژیک این شرکت از “سختافزار گرافیکی” به سمت “سختافزار اختصاصی زبانی” است.

نظر شخصی من این است که انویدیا با این حرکت، عملاً رقبای احتمالی را قبل از بزرگ شدن بلعید. این یعنی انحصار انویدیا در بازار اخبار هوش مصنوعی و سختافزار، احتمالاً تا سال ۲۰۳۰ تمدید شده است.

آینده سختافزار در هوش روز

این توافق نشان میدهد که دوره “هر کاری را با GPU انجام دهیم” به پایان رسیده است. سایت اخبار هوش مصنوعی هوش روز پیشبینی میکند که تا پایان سال ۲۰۲۵، شاهد عرضه کارتهای جدیدی از انویدیا باشیم که برچسب “AI Accelerator” دارند و دیگر نام GPU را یدک نمیکشند.

این خبر برای سهامداران انویدیا نوید روزهای سبزتر و برای توسعهدهندگان هوش مصنوعی، نوید اپلیکیشنهایی با سرعت نور را میدهد. ما در «هوش روز» لحظه به لحظه جزئیات فنی این همکاری را برای شما پوشش خواهیم داد.

سوالات متداول

انویدیا مجوز فناوری LPU شرکت Groq را دریافت و مدیرعامل آن را استخدام کرد تا سرعت پردازش هوش مصنوعی را متحول کند.

برخلاف GPU که بر آموزش تمرکز دارد، LPUهای Groq سرعت پاسخدهی (Inference) مدلها را تا ۱۰ برابر افزایش میدهند.

او خالق TPU گوگل و موسس Groq است؛ حضور او در انویدیا مسیر ساخت سختافزارهای هیبریدی و فوقسریع AI را هموار میکند.

با ادغام این فناوریها، باید منتظر هوش مصنوعی بلادرنگ (Real-time) بدون هیچگونه تاخیر و مکث در پاسخگویی باشیم.